- 品牌

- Nvidia

- 型號

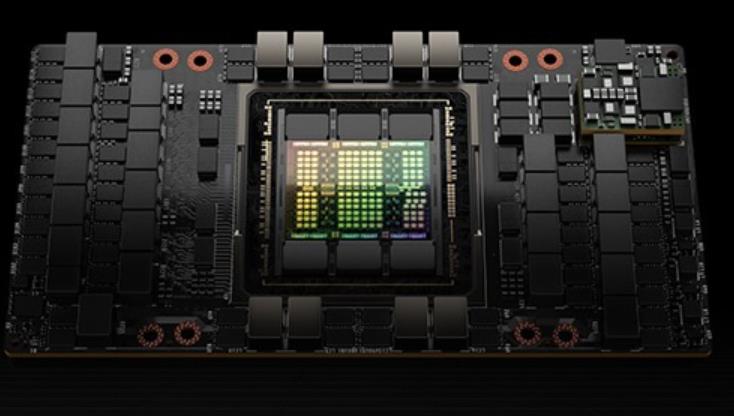

- H100

- 磁盤陣列

- Raid10

- CPU類型

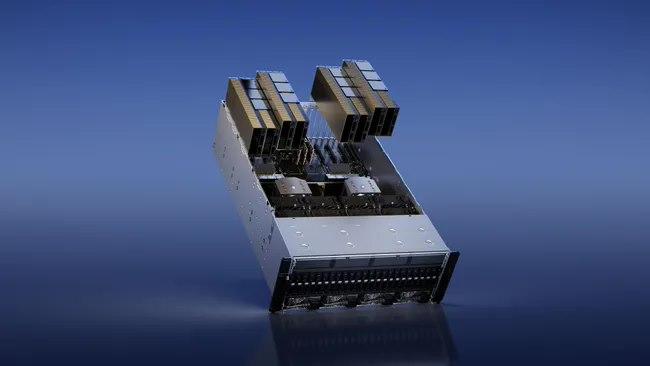

- Intel Platinum 8558 48 核

- CPU主頻

- 2.10

- 內存類型

- 64G

- 硬盤容量

- Samsung PM9A3 7.6TB NVMe *8

- 廠家

- SuperMicro

- 標配CPU個數

- 2個

- 最大CPU個數

- 4個

- 內存容量

- 64G*32

- GPU

- 8 H100 80GB NVlink

我們非常重視客戶反饋,并不斷改進其服務和產品質量。通過定期回訪和客戶滿意度調查,ITMALL.sale 了解客戶在使用 H100 GPU 過程中的需求和建議,及時解決客戶遇到的問題。ITMALL.sale 還設有專門的客戶服務中心,提供7x24小時的在線支持和電話咨詢,確保客戶在任何時候都能夠獲得幫助。ITMALL.sale 的目標是通過不斷優化服務,提升客戶滿意度,成為客戶心中值得信賴的 H100 GPU 供應商。ITMALL.sale 的客戶服務團隊經過嚴格培訓,具備專業的技術知識和良好的服務態度,能夠為客戶提供的支持和幫助。H100 GPU 降價特惠,先到先得。英偉達H100GPU how much

網絡、存儲、RAM、CPU)以及銷售它的人的利潤率和支持級別。該范圍的**,包括支持在內的$360k-380k,是您可能期望與DGXH100相同規格的。1xHGXH100(PCIe)和8xH100GPU大約是300k美元,包括支持,具體取決于規格。PCIe卡的市場價格約為30k-32k美元。SXM卡并不是真正作為單張卡出售的,因此很難在那里給出定價。通常作為4-GPU和8-GPU服務器出售。大約70-80%的需求是SXMH100,其余的是PCIeH100。SXM部分的需求呈上升趨勢,因為PCIe卡是前幾個月***可用的卡。鑒于大多數公司購買8-GPUHGXH100(SXM),每360個H380的大約支出為8k-100k,包括其他服務器組件。DGXGH200(提醒一下,包含256xGH200,每個GH200包含1xH100GPU和1xGraceCPU)的成本可能在15mm-25mm之間-盡管這是一個猜測,而不是基于定價表。19需要多少個GPU?#GPT-4可能在10,000到25,000架A100之間接受過訓練。20Meta擁有大約21,000架A100,特斯拉擁有約7,000架A100,穩定AI擁有約5,000架A100。21獵鷹-40B在384架A100上進行了訓練。22Inflection使用3,500H100作為其。23順便說一句,到22月,我們有3k在運行。并且***運行超過5.<>k。——穆斯塔法·蘇萊曼(MustafaSuleyman)。xfusionH100GPU貨期。對于開發者來說,H100 GPU 的穩定性和高能效為長時間的開發和測試提供了可靠保障.

交換機的總吞吐率從上一代的Tbits/sec提高到Tbits/sec。還通過多播和NVIDIASHARP網內精簡提供了集群操作的硬件加速。加速集群操作包括寫廣播(all_gather)、reduce_scatter、廣播原子。組內多播和縮減能提供2倍的吞吐量增益,同時降低了小塊大小的延遲。集群的NVSwitch加速降低了用于集群通信的SM的負載。新的NVLink交換系統新的NVLINK網絡技術和新的第三代NVSwitch相結合,使NVIDIA能夠以前所未有的通信帶寬構建大規模的NVLink交換系統網絡。NVLink交換系統支持多達256個GPU。連接的節點能夠提供TB的全向帶寬,并且能夠提供1exaFLOP的FP8稀疏AI計算能力。PCIeGen5H100集成了PCIExpressGen5×16通道接口,提供128GB/sec的總帶寬(單方向上64GB/s),而A100包含的Gen4PCIe的總帶寬為64GB/sec(單方向上為32GB/s)。利用其PCIeGen5接口,H100可以與性能高的x86CPU和SmartNICs/DPUs(數據處理單元)接口。H100增加了對本地PCIe原子操作的支持,如對32位和64位數據類型的原子CAS、原子交換和原子取指添加,加速了CPU和GPU之間的同步和原子操作H100還支持SingleRootInput/OutputVirtualization(SR-IOV)。

增加了一個稱為線程塊集群(ThreadBlockCluster)的新模塊,集群(Cluster)是一組線程塊(ThreadBlock),保證線程可以被并發調度,從而實現跨多個SM的線程之間的**協作和數據共享。集群還能更有效地協同驅動異步單元,如張量內存***(TensorMemoryAccelerator)和張量NVIDIA的異步事務屏障(“AsynchronousTransactionBarrier”)使集群中的通用CUDA線程和片上***能夠有效地同步,即使它們駐留在單獨的SM上。所有這些新特性使得每個用戶和應用程序都可以在任何時候充分利用它們的H100GPU的所有單元,使得H100成為迄今為止功能強大、可編程性強、能效高的GPU。組成多個GPU處理集群(GPUProcessingClusters,GPCs)TextureProcessingClusters(TPCs)流式多處理器(StreamingMultiprocessors,SM)L2CacheHBM3內存控制器GH100GPU的完整實現8GPUs9TPCs/GPU(共72TPCs)2SMs/TPC(共144SMs)128FP32CUDA/SM4個第四代張量/SM6HBM3/HBM2e堆棧。12個512位內存控制器60MBL2Cache第四代NVLink和PCIeGen5H100SM架構引入FP8新的Transformer引擎新的DPX指令H100張量架構專門用于矩陣乘和累加(MMA)數學運算的高性能計算,為AI和HPC應用提供了開創性的性能。H100 GPU 降價特惠,趕快搶購。

H100中新的第四代TensorCore架構提供了每SM的原始稠密和稀疏矩陣數學吞吐量的兩倍支持FP8、FP16、BF16、TF32、FP64、INT8等MMA數據類型。新的TensorCores還具有更**的數據管理,節省了高達30%的操作數交付能力。FP8數據格式與FP16相比,FP8的數據存儲需求減半,吞吐量提高一倍。新的TransformerEngine(在下面的章節中進行闡述)同時使用FP8和FP16兩種精度,以減少內存占用和提高性能,同時對大型語言和其他模型仍然保持精度。用于加速動態規劃(“DynamicProgramming”)的DPX指令新引入的DPX指令為許多DP算法的內循環提供了高等融合操作數的支持,使得動態規劃算法的性能相比于AmpereGPU高提升了7倍。L1數據cache和共享內存結合將L1數據cache和共享內存功能合并到單個內存塊中簡化了編程,減少了達到峰值或接近峰值應用性能所需的調優;為這兩種類型的內存訪問提供了佳的綜合性能。H100GPU層次結構和異步性改進關鍵數據局部性:將程序數據盡可能的靠近執行單元異步執行:尋找的任務與內存傳輸和其他事物重疊。目標是使GPU中的所有單元都能得到充分利用。線程塊集群(ThreadBlockClusters)提出背景:線程塊包含多個線程并發運行在單個SM上。H100 GPU 特價銷售,趕快搶購。H100GPU一臺多少錢

H100 GPU 適用于智能制造領域。英偉達H100GPU how much

在人工智能應用中,H100 GPU 的計算能力尤為突出。它能夠快速處理大量復雜的模型訓練和推理任務,大幅縮短開發時間。H100 GPU 的并行計算能力和高帶寬內存使其能夠處理更大規模的數據集和更復雜的模型結構,提升了AI模型的訓練效率和準確性。此外,H100 GPU 的高能效比和穩定性也為企業和研究機構節省了運營成本,是人工智能開發的理想選擇。對于科學計算而言,H100 GPU 提供了強大的計算能力。它能夠高效處候模擬、基因組學研究、天體物理學計算等復雜的科學任務。H100 GPU 的大規模并行處理單元和高帶寬內存可以提升計算效率和精度,使科學家能夠更快地獲得研究成果。其穩定性和可靠性也為長時間計算任務提供了堅實保障,是科學計算領域不可或缺的工具。英偉達H100GPU how much

- QatarH100GPU list price 2025-07-09

- HPEH100GPU how much 2025-07-08

- NVLINKH100GPU優惠 2025-07-08

- 湖北H100GPU 2025-07-08

- 40GH100GPU總代 2025-07-08

- SMXH100GPU discount 2025-07-04

- 北京H100GPU折扣 2025-07-04

- TaiwanH100GPU how much 2025-07-03

- Iran超微H100GPU 2025-07-03

- 深圳HPEH100GPU 2025-07-01

- 英偉達H100GPU how much 2025-07-01

- IranHPEH100GPU 2025-06-30