- 品牌

- Nvidia

- 型號

- H100

- 磁盤陣列

- Raid10

- CPU類型

- Intel Platinum 8558 48 核

- CPU主頻

- 2.10

- 內存類型

- 64G

- 硬盤容量

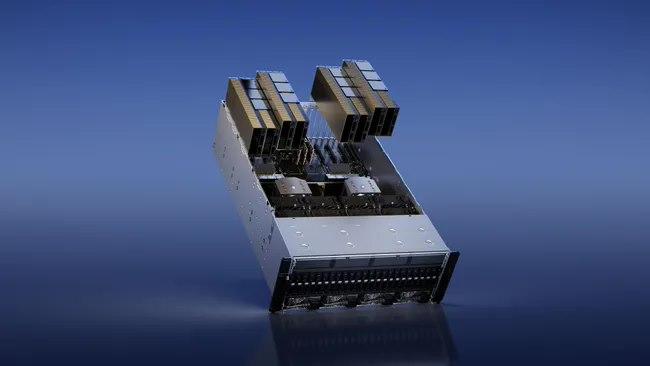

- Samsung PM9A3 7.6TB NVMe *8

- 廠家

- SuperMicro

- 標配CPU個數

- 2個

- 最大CPU個數

- 4個

- 內存容量

- 64G*32

- GPU

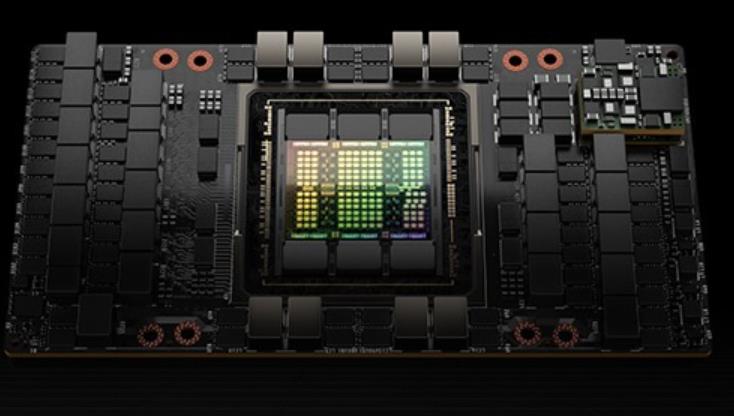

- 8 H100 80GB NVlink

我理解的就是這些等待的線程在等待的時候無法執行其他工作)也是一個分裂的屏障,但不對到達的線程計數,同時也對事務進行計數。為寫入共享內存引入一個新的命令,同時傳遞要寫入的數據和事務計數。事務計數本質上是對字節計數異步事務屏障會在W**t命令處阻塞線程,直到所有生產者線程都執行了一個Arrive,所有事務計數之和達到期望值。異步事務屏障是異步內存拷貝或數據交換的一種強有力的新原語。集群可以進行線程塊到線程塊通信,進行隱含同步的數據交換,集群能力建立在異步事務屏障之上。H100HBM和L2cache內存架構HBM存儲器由內存堆棧組成,位于與GPU相同的物理封裝上,與傳統的GDDR5/6內存相比,提供了可觀的功耗和面積節省,允許更多的GPU被安裝在系統中。devicememory:駐留在HBM內存空間的CUDA程序訪問的全局和局部內存區域constantcache:駐留在devicememory內的不變內存空間texturecache:駐留在devicememory內的紋理和表面內存空間L2cache:對HBM內存進行讀和寫servicesmemory請求來源于GPU內的各種子系統HBM和L2內存空間對所有SM和所有運行在GPU上的應用程序都是可訪問的。HBM3或HBM2eDRAM和L2緩存子系統都支持數據壓縮和解壓縮技術。H100 GPU 提供高效的功耗管理。Iran超微H100GPU

使用張量維度和塊坐標來定義數據傳輸,而不是每個元素尋址。TMA操作是異步的,利用了基于共享內存的異步屏障。TMA編程模型是單線程的,選擇一個經線程中的單個線程發出一個異步TMA操作(cuda::memcpy_async)來復制一個張量,隨后多個線程可以在一個cuda::barrier上等待完成數據傳輸。H100SM增加了硬件來加速這些異步屏障等待操作。TMA的一個主要***是它可以使線程自由地執行其他的工作。在Hopper上,TMA包攬一切。單個線程在啟動TMA之前創建一個副本描述符,從那時起地址生成和數據移動在硬件中處理。TMA提供了一個簡單得多的編程模型,因為它在復制張量的片段時承擔了計算步幅、偏移量和邊界計算的任務。異步事務屏障(“AsynchronousTransactionBarrier”)異步屏障:-將同步過程分為兩步。①線程在生成其共享數據的一部分時發出"到達"的信號。這個"到達"是非阻塞的。因此線程可以自由地執行其他的工作。②終線程需要其他所有線程產生的數據。在這一點上,他們做一個"等待",直到每個線程都有"抵達"的信號。-***是允許提前到達的線程在等待時執行的工作。-等待的線程會在共享內存中的屏障對象上自轉(spin)。天津NvdiaH100GPUH100 GPU 支持氣候模擬計算任務。

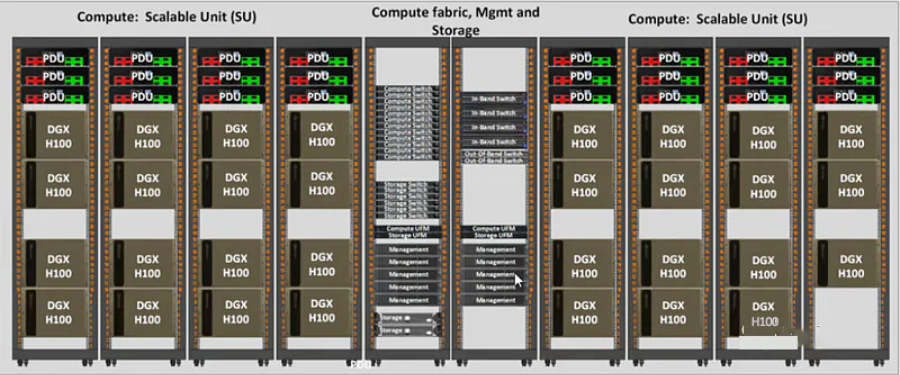

H100GPU層次結構和異步性改進關鍵數據局部性:將程序數據盡可能的靠近執行單元異步執行:尋找的任務與內存傳輸和其他事物重疊。目標是使GPU中的所有單元都能得到充分利用。線程塊集群(ThreadBlockClusters)提出背景:線程塊包含多個線程并發運行在單個SM上,這些線程可以使用SM的共享內存與快速屏障同步并交換數據。然而,隨著GPU規模超過100個SM,計算程序變得更加復雜,線程塊作為編程模型中***表示的局部性單元不足以大化執行效率。Cluster是一組線程塊,它們被保證并發調度到一組SM上,其目標是使跨多個SM的線程能夠有效地協作。GPC:GPU處理集群,是硬件層次結構中一組物理上總是緊密相連的子模塊。H100中的集群中的線程在一個GPC內跨SM同時運行。集群有硬件加速障礙和新的訪存協作能力,在一個GPC中SM的一個SM-to-SM網絡提供集群中線程之間快速的數據共享。分布式共享內存(DSMEM)通過集群,所有線程都可以直接訪問其他SM的共享內存,并進行加載(load)、存儲(store)和原子(atomic)操作。SM-to-SM網絡保證了對遠程DSMEM的快速、低延遲訪問。在CUDA層面。集群中所有線程塊的所有DSMEM段被映射到每個線程的通用地址空間中。

–私有云執行官什么時候會有H100繼任者?#可能要到2024年底(2024年中期到2025年初)才會公布,基于Nvidia架構之間的歷史時間。在此之前,H100將成為NvidiaGPU的前列產品。(GH200和DGXGH200不算在內,它們不是純GPU,它們都使用H100作為他們的GPU)會有更高的顯存H100嗎?#也許是液冷120GBH100s。短缺何時結束?#與我交談過的一個團體提到,它們實際上在2023年底之前已售罄。采購H100#誰賣H100?#戴爾,HPE,聯想,Supermicro和Quanta等OEM銷售H100和HGXH100。30當你需要InfiniBand時,你需要直接與Nvidia的Mellanox交談。31因此,像CoreWeave和Lambda這樣的GPU云從OEM購買,然后租給初創公司。超大規模企業(Azure,GCP,AWS,Oracle)更直接地與Nvidia合作,但他們通常也與OEM合作。即使對于DGX,您仍然會通過OEM購買。您可以與英偉達交談,但您將通過OEM購買。您不會直接向Nvidia下訂單。交貨時間如何?#8-GPUHGX服務器上的提前期很糟糕,而4-GPUHGX服務器上的提前期很好。每個人都想要8-GPU服務器!如果一家初創公司***下訂單,他們什么時候可以訪問SSH?#這將是一個交錯的部署。假設這是一個5,000GPU的訂單。他們可能會在2-000個月內獲得4,000或4,5個。H100 GPU 降價特惠,先到先得。

他們與來自大云(Azure,GoogleCloud,AWS)的一些人交談,試圖獲得許多H100。他們發現他們無法從大云中獲得大量分配,并且一些大云沒有良好的網絡設置。因此,他們與其他提供商(如CoreWeave,Oracle,Lambda,FluidStack)進行了交談。如果他們想自己購買GPU并擁有它們,也許他們也會與OEM和Nvidia交談。終,他們獲得了大量的GPU。現在,他們試圖獲得產品市場契合度。如果不是很明顯,這條途徑就沒有那么好了-請記住,OpenAI在更小的模型上獲得了產品市場契合度,然后將它們擴大了規模。但是,現在要獲得產品市場契合度,您必須比OpenAI的模型更適合用戶的用例,因此首先,您將需要比OpenAI開始時更多的GPU。預計至少到100年底,H2023將短缺數百或數千次部署。到2023年底,情況將更加清晰,但就目前而言,短缺似乎也可能持續到2024年的某些時間。GPU供需之旅。大版本取得聯系#作者:克萊·帕斯卡。問題和筆記可以通過電子郵件發送。新帖子:通過電子郵件接收有關新帖子的通知。幫助:看這里。自然的下一個問題-英偉達替代品呢?#自然的下一個問題是“好吧,競爭和替代方案呢?我正在探索硬件替代方案以及軟件方法。提交我應該探索的東西作為此表格的替代方案。例如。H100 GPU 提供高效的數據分析能力。天津NvdiaH100GPU

H100 GPU 優惠促銷,馬上下單。Iran超微H100GPU

在大數據分析領域,H100 GPU 展現了其強大的數據處理能力。它能夠快速處理和分析海量數據,提供實時的分析結果,幫助企業做出更快的決策。無論是在金融分析、市場預測還是用戶行為分析中,H100 GPU 都能提升數據處理速度和分析準確性。其高能效設計不僅提升了性能,還為企業節省了大量的能源成本,成為大數據分析的理想硬件。H100 GPU 在云計算中的應用也非常多。它的高并行處理能力和大帶寬內存使云計算平臺能夠高效地處理大量并發任務,提升整體服務質量。H100 GPU 的靈活性和易管理性使其能夠輕松集成到各種云計算架構中,滿足不同客戶的需求。無論是公共云、私有云還是混合云環境,H100 GPU 都能提供強大的計算支持,推動云計算技術的發展和普及。Iran超微H100GPU

- QatarH100GPU list price 2025-07-09

- HPEH100GPU how much 2025-07-08

- NVLINKH100GPU優惠 2025-07-08

- 湖北H100GPU 2025-07-08

- 40GH100GPU總代 2025-07-08

- SMXH100GPU discount 2025-07-04

- 北京H100GPU折扣 2025-07-04

- TaiwanH100GPU how much 2025-07-03

- Iran超微H100GPU 2025-07-03

- 深圳HPEH100GPU 2025-07-01

- 英偉達H100GPU how much 2025-07-01

- IranHPEH100GPU 2025-06-30